|

記事検索 |

最新ニュース |

|

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

「イノベーションジャパン2008 -大学見本市」レポート |

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

主催は独立行政法人 科学技術振興機構(JST)と独立行政法人新エネルギー・産業技術総合開発機構(NEDO)。文部科学省、経済産業省、内閣府、日経BP社が共催している。出展団体数は全部で479。今年で5回目となる。 「環境」「新エネルギー・省エネルギー」「アグリ・バイオ」「医療・健康」「ナノテク・材料」「ものづくり」「IT」の7分野の研究成果が出展されているが、本誌ではロボット関連の展示を中心に、一部を簡単にご紹介する。 ● 大学・TLOゾーン 立命館大学総合理工学研究機構先端ロボティクス研究センター教授の金岡克弥氏らは、「マンマシーンシナジーエフェクタ」を出展している。本誌でもこれまで何度か紹介している「人間機械相乗効果器」だ。ロボットのパワーと人の器用さを両立させた、機械の実現を狙った研究である。今回は下肢のパワーを増幅する「パワーペダル」を出展。現時点で片足自由度は3だが、将来的には6に増やしたいという。

東京工業大学精密工学研究所准教授の張暁林氏らは、人間の眼球運動特性に近い視線安定化システムや、それらの技術を応用した広範囲監視システム、移動型監視ロボットを実物で出展している。視線安定化システムは9自由度を持ち、振動や併進・回転運動などの外乱に対して安定して画像を取得できるシステム。対象のスムーズな追跡やステレオ視による距離計測ができる。 広範囲監視システムは100m先の動く物体を検出でき、望遠ズームできる。移動型監視ロボットは180度の視野と人間でいうところの視力1.0くらいの高い画像分解能を持つという。重要社会インフラ施設の監視をねらっている。同研究室の技術は小型モーターコントローラーやカメラリンク出力ボードなども事業化を狙っているそうだ。

岡山県立大学情報工学部渡辺富夫教授は「人を引き込む身体性メディア場の生成・制御技術」として、音声に合わせてうなずき動作をするロボットなどを出展している。渡辺教授の研究は、セガトイズから2008年9月末に発売される「ペコッぱ」として商品化されている。人の会話のタイミングに合わせて、少しうなづいたり深くうなづいたりする癒し系トイだ。現在はタイピングに合わせてソフトウェア・エージェントがうなずくという研究も行なっているそうだ。

東京農工大学工学府・工学部機械システム工学科遠山研究室は、球面超音波モータを使った「管内検査ロボット」を出展している。カメラや駆動部のほかLEDや姿勢検出センサーを内蔵したヘッド部の直径は4cm、奥行き5cm。カメラをどの方向にも向けられ、内径5cmの管を検査できるという。

埼玉工業大学工学部ヒューマン・ロボット学科和田研究室は、4輪駆動のロボット車椅子を今年も出展している。段差踏破性能が上がり、また、アシスト機能を付けることにより簡単に動かせるようになった。ハンドル部分ではなく座面下の力センサーを使ってアシストを行なうことで、たとえばユーザーが座ったままでも机に対して体を引き寄せられるといった、より現実的なシーンでの活用範囲が広がったという。

「感性」をテーマに研究を進めている関西学院大学理工学部情報科学科長田典子教授の研究室は、CGでの布の質感表現や、モーションキャプチャとMIDIデータを使ってピアノ演奏する指の運指をCG化するアプリケーションなどのほか、ダンスロボットの研究を出展している。これはキーモーションを予め決めておき、そこに特定音楽を与えると、その音楽のビート情報を抽出して間の動きを補完して繋ぐというもの。敢えて実物のロボットを使っている理由は、そのほうが見ている人に強い印象を与えられるからだという。

中部大学工学部情報工学科藤吉弘亘研究室は、デンソーと共同研究している標識認識技術のほか、動画像を理解する技術に関する展示を行なっている。たとえば歩行者の動きを認識することで、道路や店内の通路上で人の流れがどのようになっているか、流れを可視化することができる。ある交差点で人の動きを見ると、角を曲がったところで人の流れが左側通行から右側通行へと変化する様子などが分かる。 そのほか、講義ビデオから自動的に講師の位置を認識し、しかもプロのカメラマンの動きを研究することによって、余計なパンなどを省いた講義ビデオを自動生成するアプリケーションなどがパネルで解説されている。なお同研究室ではロボットの視覚機能の実現をアプリケーションの1つに掲げている。 筑波大学システム情報工学研究科知能機能システム専攻星野聖研究室は、柔らかい光学式の圧力センサーを出展している。柔軟な表面の変形の様子を捉えられる圧力センサーだが、表面は薄く、システム全体はけっこう大きい。 九州大学大学院システム情報科学研究院 古川研究室の研究をベースとしたMIMO-MESH PROJECTは、簡単に無線LANエリアを形成するルーター「PicoCELA-1」を出展している。1台をネットに繋いで、どれか1台のリルートスイッチを押すだけで最適な無線中継網を形成し、広い範囲での無線LANエリアを形成するというものだ。 「IPT方式」という独自のパケット伝送プロトコルを使うことで、従来の中継伝送方式に比べて10段ホップで約2倍のスループットを実現しているという。このような技術がはやく普及して、大学内をはじめ公的な場所だけでも自由に無線LANに繋がる時代が来てほしいものだ。

東北工業大学工学部知能エレクトロニクス学科水野研究室は、「バーチャルカメレオン」という両眼に任意の独立した視野を与える装置を出展している。上部に2台のカメラを付けたヘルメットをかぶり、その映像をディスプレイを通して見ることで、両眼にそれぞれ独立した視野を与える。カメラのパン・チルトは手元のジョイスティックで行なえる。取りあえずの用途はエンターテインメント。 実際に体験させてもらったところ、思った以上に自然に右左の視野を得ることができた。両眼視野闘争のようなことが起きるかと思ったのだが、右目画像・左目画像の切換はほぼ自分の意志で自在に行なえる。ただし、人の顔のようにおそらく無意識に引きつけられるものがあると、そちらに引きずられるようだ。なお、中には使用中に気分が悪くなる人もいるとのことだ。

武蔵工業大学知識工学部情報科学科視覚メディア研究室は、「静止画による大画面動画広告」を出展している。1枚の静止画を印刷したポスターで、動画表示を可能にするという技術である。 ロボットには無関係だが面白いのでご紹介すると、原理はパラパラマンガだ。パラパラマンガの1枚1枚を画像に重畳して印刷する。それを動かし、フィルターを通してみると動いて見えるというわけだ。フィルターも紙もプリンターで印刷可能なため、非常に安価に大画面動画広告を実現できるという。

● パネルによる展示も 東洋大学共生ロボット研究センターは「高齢社会対応型ナチュラルセンシングシステム」という研究を展示。2つの「ロボット実験住宅」を建てて内部をセンシングし、ライフログやその他を取って、人間と共生できるロボットの開発を行なおうというもの。ロボットのデザインにも気を配り、インテリア家電としてあまり目立たないものを目指しているという。特にロボットに対して命令を与える際の声を分析することで感情抽出を行ない、それに対してフィードバックをかけている点が特徴だそうだ。

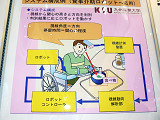

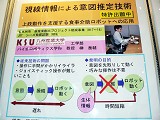

九州産業大学工学部教授の榊泰輔氏らは、「食事介助ロボットの研究開発」という研究をパネル出展。上肢運動に障害を持った人が食事をするためのロボットで、特徴は操作を視線入力で行なうこと。操作デバイスを随意的に操作者が指示して与える食事介助ロボットに対して、このロボットの場合は視線情報から使用者の意図を推定して先に動き始めるため、遅れが少ないという。また随意的操作と組み合わせたロボットの動作指令も生成できるので、ロボットが動作中に操作者の意図が変わっても即応できるという。また発電所や化学プラントなどでの操作インターフェイスへの応用も視野に入れているそうだ。 新潟大学工学部福祉人間工学科教授の岡田徳次氏と、同・自然科学研究科情報理工学専攻助教の清水年美氏は「対地適応性を有する1人乗り用脚車輪切換え移動装置」というパネルを出展している。8本の脚をもった脚車輪型の1人乗りロボットで、バリアフリーのシニアカーの開発を目指しているという。動作自由度を同期させて運動機構と制御を簡略化した点が特徴だそうだ。残念ながら動画等の展示はない。 九州大学イメージ・メディア理解研究室では「並列計算機による実時間身体姿勢計測」という研究を出展している。8台のカメラとPCクラスターを使ったモーションキャプチャの一種だが、人間の肌の色をマーカーとしてシルエットを計測することによって頭手足の3次元位置、すなわち姿勢を推測・決定する。これを応用してビリヤードショット中の姿勢を計測することで、プレイヤーの姿勢矯正なども研究中だという。

● 大学発ベンチャーゾーン 北九州TLOブースでは小型潜水機「やじろBAY」が見られる。46×58.3×44.7cm(幅×奥行き×高さ)。重量26kg。スラスターを5機そなえ、50mまで潜って、最大2ノット(およそ1m/秒)で移動できる。電源は船上から供給され、通信は光ファイバーで双方向通信が可能。北九州市立大学教授山本郁夫氏、九州工業大学准教授の石井和男氏、同准教授アミール・ナシライ氏、そしてNPO法人環境テクノロジーセンターが開発したもの。本体上方につけられた浮体による「逆やじろべえ」のような浮力調整機構で、傾斜計や慣性センサーを使わずにローリング・ピッチングを抑制する。おもちゃの潜水艇のようだが姿勢制御にタイムラグがなく、カメラや計器類など搭載物を変更しても重心・浮心を簡単に変更できるという。現在、製品化するメーカーを募集している段階だそうだ。 東工大画像情報工学研究施設熊澤研究室の研究成果に基づくベンチャー、インピュテクス株式会社は、触覚に情報提示するためのシステムを構築するための「次世代ユーザーインターフェイス開発用キット」と、それを使ったアプリケーションの例として、触覚刺激機構付きジェスチャー入力リモコンなどを展示している。 情報家電のリモコンなどはメニュー画面などを扱う必要があるが、画面上でスイッチを動かしても触覚のフィードバックはない。それを返してやろうというもので、振動覚を与えるためにサーボモーターが内蔵されている。これが直接応用されるということはないだろうが、今後触覚フィードバックを使ったインターフェイス関連機器は増えてくるのではないかと思われる。

■URL イノベーションジャパン2008 -大学見本市 http://expo.nikkeibp.co.jp/innovation/ ■ 関連記事 ・ 「イノベーション・ジャパン2007」レポート ~ロボット技術を応用した研究成果が多数展示(2007/09/13) ・ マイクロソフトとZMP、Robotics Studio活用で協力開始 ~「イノベーション・ジャパン2007」内で発表、デモ(2007/09/13) ・ 医療・介護から多次元ファジィによるロボットサッカーまで(2006/09/14)

( 森山和道 )

- ページの先頭へ-

|