認知ロボットの実験から考える「自己」とは?

~理研の谷淳氏が東京財団「VCASI」で講演

12月15日、東京財団の研究プロジェクト「VCASI(ヴィカシ。Virtual Center for Advanced Studies in Institution=制度にかかわる仮想高等研究所=仮想制度研究所の略称)」(主宰:青木昌彦スタンフォード大学名誉教授)は、独立行政法人理化学研究所(理研)の脳科学研究センターにて、認知発達ロボティクスの研究を行なっている谷淳氏によるセミナーを開催した。

谷淳氏は「脳・認知ロボットの実験から考える内在的な自己について」と題して講演した。テーマは、自己のありようについて。自己には「最小自己」「社会的自己」「自己参照的自己」の3段階があるという。そして「自己」は、過去の回帰と、将来の予測の相互作用において自己組織化される臨界的な状況において存在するものだと述べた。レポートする。

●身体性と反射だけでは知的なロボットはできない

|

| 独立行政法人理化学研究所 脳科学研究センター 動的認知行動研究チーム チームリーダー 谷淳氏 |

谷淳氏は、1981年に早稲田大学理工学部機械工学科を卒業。最初は千代田化工建設株式会社に入社し、プラント配管設計業務を行なっていた。講演はその当時の思い出から始まった。あるとき、谷氏らは会社で移動ロボットを見に行った。移動ロボットは冷蔵庫の前に止まり、「これは冷蔵庫です」といったそうだ。同僚たちは驚いていたが、谷氏はその腕も持たないロボットにとって冷蔵庫とは何だろうかと考えたのだという。人間であれば、冷蔵庫の中にはビールが冷えていて云々かんぬんといろいろなことを想像する。しかしロボットにはそういう知識はない。そのロボットにとって冷蔵庫という表象は何を意味しているのだろうか。そんなことを考えたのだという。

また、あるとき谷氏は、海から10kmくらいのパイプラインが来ていてネットワークになっている大規模な配管現場へ調査に行なった。パイプラインに異常事態が発生したときには緊急遮断弁を閉じる必要がある。そうしたときに、配管がどうなるか、圧力計などを使って調べるという仕事だった。谷氏は計器室にいって、緊急遮断弁を閉じた。するとウォーターハンマーと呼ばれる現象が発生した。音速で圧力波が伝わっていき、10km先の配管まで伝わり、また反響が返ってくる。配管を伝わって音が戻ってくるのである。ネットワーク状の配管を、音波がガンガンと伝わり、それがやがてあるパターンを作り、ガンガンと反響音が響いたという。その現象は5、6時間も続いた。谷氏は、パターンが出ては消えていくその様子を観察しながら、こういうものが知能の始まりなんじゃないかと考えたという。

こうして「配管の設計をやってる場合ではない」と考えた谷氏は、80年代後半に渡米。スタンフォード大学そのほかでコネクショニズムを学び、ミシガン大学工学部にて人工知能の研究で修士号を取得した。だが、「記号」を基本にした旧来の人工知能の研究には違和感があったという。記号には重さも何もなく、自由に操作ができてしまう。処理に重さも時間かかからない、それが知能なのだろうか?

谷氏は日本に帰国して、ソニーコンピュータサイエンス研究所を経て、現在に至っている。日本に帰ってきたころに、ロドニー・ブルックスのサブサンプション・アーキテクチャーそのほかに接した。それまでのロボットは、いわば「神の視点」で俯瞰して世界モデルを作り、鳥瞰図でプランを描いてしまい、そのなかで動くというのが前提だった。だがブルックスはそうではなく、頭ではなく身体的な反射を使うことで、もっと環境に合わせていろんなことができるよといったわけだ。当時、その考え方はブームになった。1990年ごろの話だ。

だが、谷氏は「ブルックスの考え方は面白いが、行き過ぎているのではないか。身体性や反射だけではないのではないか」と思ったという。それではパチンコ台でパチンコ玉を弾くとあちこちに反射するのと同じで、複雑なふるまいはするだろうが面白いものは出てこない。では何が必要なのか。認知ロボットを作るには「志向性」が非常に大事なのではいかと考えた。トップダウンもだめだが、ただ身体性、反射だけでも面白くない。何かしら、世界と相互作用をしながら、その過程に志向性があり、そのなかで相互作用をして、表現したいものに向かっていく。そういうものが動物の知能にはあるのではないだろうか。そういうものがあるからこそ、言語のようなものもできてくるのではないだろうか。こうして谷氏は力学系の考え方を使った独自のアプローチで認知の問題に立ち向かい始めた。

●自己の3つの論点:「最小自己」「社会的自己」「自己参照的自己」

|

| 自己の3つの論点 |

谷氏は、力学系アプローチで認知の問題、志向性や自己、意識といった問題に近づいていこうとしているが、力学系だけで終わってしまっては意味がない。まず「自己」の問題を考えることが重要だという。自己の問題を考えないと、「環境」と「自己」の相互作用も考えられないし、第3者との相互作用においても「自己」の問題は重要になるからだ。単なる反射で動くのではなく、志向性を持ったロボットのためには自己の問題が大事だという。

谷氏はオートポイエーシス理論で知られるフランシスコ・バレーラの考え方を紹介し、ニューロサイエンスと非線形力学を結びつけて、関係性として理解していくことが重要だと述べた。また意識の研究においても、「ロボットの意識を作りました」というような言い方をすると、非常に表面的になってしまうので、意識の問題について、モデルをつくりながら、まとめていくという立場なのではないかと語った。

さて、自己については3つの論点があるという。最初にふれた「最小自己(ミニマルセルフ)」「社会的自己(ソーシャルセルフ)」「自己参照的自己」の3つだ。ウィリアム・ジェイムズによれば「最小自己」とは、自分を意識するというのは非常に瞬間的であり、その瞬間、刹那の自己意識、これを最小単位とする意識があるという考え方だ。最小自己が現れたり消えたりしている、それが意識の土台になるのではないかという。ソーシャルセルフとは、他者との関係性で捉えられる自己である。「自己参照的自己」とは「自己を参照する自己」である。自分の履歴をおって、いまここに自分がいるとという視点を持っている自己だ。ミニマルセルフが主観的な経験にもとづいているのに対し、自分自身をメタな視点から上から、客観的に見る自己である。

また、フッサールやハイデガーは時間の問題が非常に重要だと語っている。谷氏は「ロボットをやっていると常に時間の問題がある。特にロボットが自分のやったことを学習したり予測するには常に時間の問題がつきまとう。時間の単位が物理的な時間で良いのか。それは問題になる」と語った。なぜか。昔の人工知能は神の視点で世界モデルをつくっていく。そのときには一般的な規定に基づいた時間を作って行くことになる。だが我々は「手を伸ばし始めてこのコップを3.5秒で取る、そのために」といったような計算をするわけではない。より身近な自分自身の身体感覚で時間も処理しているように思われる。またフッサールは死の問題まで考えることが重要だと述べているという。

●視覚を持って予測する移動ロボット

|

| 視覚を持った移動ロボット。環境に5つのランドマークを置き、予測させる |

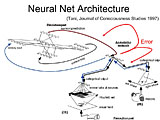

谷氏は、15年くらい前に研究していたロボットの実験から示した。視覚を持った移動ロボットで、移動の感覚はエンコーダーからタイヤの回転数として得る。ロボットは障害物があるコースのなかを移動して行く。ロボットは動くに従って、学習していき、その角を曲がると何が見えるかということを学習していく。ロボットは何回も回っていくうちにランドマークの出現を予測していく。前もって自分が次に何を見るかを作り出して、それを確認していくようになる。つまり自分が経験したことの記憶を作っていく。これは人間の脳でも行なわれていると考えられている、メモリー・コンソリデーションのようなものではないかと考えているという。

メモリーコンソリデーションとは一言でいえば記憶の反復による学習のことだ。ラットを使った実験によれば、ラットは昼間に自分が経験した迷路学習の記憶を寝ている間に海馬から取り出し、もう一度再現して、新皮質に移し変えているといわれている。我々の記憶は単純な暗記ではない。谷氏は、記憶はあたかも酒を熟成するように長期間かけて、構造化されていくものだと述べた。そうすることで、これまでに自分が経験したことがないものを生み出したり、クリエイティビティも作り出されていくのではないかと多くの人が考えているという。

脳の中の視覚経路は、whatとwhere(How)、二つの経路があるといわれている。同様にこのロボットもそれぞれ違う経路でトップダウンで予測を行なう。予測結果と観測結果がマッチすれば問題はない。だがコンフリクトすると何かしないといけない。たとえばもっと注意深く見る。ロボットがカメラのついた首を振る速度をゆっくりしたりするわけだ。あるいはトップダウンの支配を落として、つまりトップダウンの言うことをあまり信じないで、ボトムアップの観測情報を優位にする。いまおきていることの挙動をもとに少し動いたら止まってリハースして、メモリーコンソリデーションしていく。

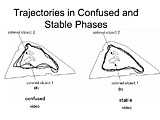

学習は随時起こる。そうすると神経回路も変わっていくわけだ。最初は予測できない。だが動いていくうちに予測できていくが、素直にそうなるわけではなく、ときどき予測が外れてしまうことがある。また実験では、モデルができては壊れるようなことが起こったという。神経回路の状態を状態空間で見ると、世界が一度ちゃんと構成されて収束したあとでもまた壊れるといったことが起こっていた。別の初期値から始めたときにもまた同じことが起きた。

世界と、ロボットの予測がうまくマッチしていないときの状況の差は、ロボットの軌跡を見ればわかる。予測できているときは非常に安定しており、いっぽう予測してないときがジグザクになっていた。これはどうしてかというと、予測がうまくいっているときはロボットはちょっと見るだけでうまく動ける。いっぽう、エラーが出ているときは障害物を長く見るため、たとえば壁の発見などがお留守になる。そういうことをやっていると、ロボットの軌跡がぐにゃぐにゃするというわけだ。

|  |  |

| ロボットのアーキテクチャ | 実験結果 | ロボットの軌跡 |

上から見ると世界は変わってない。ロボットは長く障害物を観測したり、そうしなかったりするだけだ。だが、どこかで予測が合い始めると、どんどん合ってくる。だが何かでノイズがのっていたりすると、いままでのモデルが一気に崩れてしまう。そういうのはなだれ現象に近いところがある。臨界化された状況だという。予測エラーが起きるのは自己組織化臨界に近いのではないかという。コヒーレントになっていても、それがふとしたときに崩れる。これは現象学的にいうと、ハイデガーの金槌の例のようなものだという。こういう話だ。大工が無心に釘をたたいている間は非常にうまくいく。だが、どこかで調子が崩れて釘が飛んだときに、釘、自分、環境がばらばらになる。予測のずれによってはじめて、自己と環境の違いに気づくわけだ。同様のことは、メルロポンティも述べている。うまく扱えている杖の先は自分の一部のように感じる。だが杖の先が折れてズレてしまうと自分の一部ではないようにも感じる。

何か、予測を立たないようなことをやったときにはじめて、環境、自己のブレイクが起こり、自己が知覚される。うまくいっているときは自己は知覚されない。何かあったときに、自己や意識にあがってくる。そういうものがミニマルセルフなのではないか、と谷氏は考えているという。日常生活でも、いつもと同じことがあった日のことは覚えていない。だが何か事故などのイベントがあると、記憶される。その切れ目を作るものとして「ミニマルセルフ」があるのではないかと考えているという。

谷氏はロボットを使った認知の構成論的研究を15年ほど続けている。研究していて思うのは、意識のことだけを考えていても、意識を持つロボットはできないのではないか、ということだという。この研究自体も最初は「エラーがいつまでも落ちないな、困ったな」と思っていたそうだ。ところが論文のレビュアーから「もっと現象学に寄せて考えろ」と言われたのだという。それで、このロボットが意識と関係あるのではないかと考えたのだと紹介した。谷氏は、意識についてあれこれ考えるよりも、実験を行なってそれを観察することのほうが面白いことがあると述べた。このロボットも人工知能の問題としてよく出てくる記号接地はできていない。だが、できることもある。その両者のあいだを行き来することが重要なのではないかという。

●RNN with Parametric Bias(RNNPB)

|

| Recurrent Neural Network with Parametric Bias(RNNPB) |

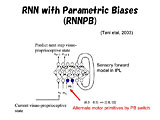

次に谷氏は、Recurrent Neural Network with Parametric Bias(RNNPB、PBニューロン+再帰的ニューラルネットワーク)を使った研究を紹介した。「RNNPB」は要するにいまの状態を入力として与えると次の状態を予測する予測器である。いまのセンサー情報を入力すると、いまの内部状態をベースに、次にセンサーがどういう情報を受け取るか予測するのだ。単純なロボットではセンサー入力は予測しない。モーターの予測だけだと単なる反射になる。でも次に来るセンサー入力そのものを予測することが重要であり、しかもセンサーとモーターの情報のフローとして予測することが重要だと考えているという。センソリー・モーターが分かれない形で次の状態を予測する。ここでいうモーターとは体性感覚の情報も含んでいる。

では「with Parametric Bias(PB)」の「PB」とは何か。PBの値が変わると、センソリー・モーターのカテゴリを変えることができる。たとえば腕を振るなら振動の信号としてみることができる。でもある状態では、ものに向かって腕を動かすというところにも働いてほしい。そう考えたときに局所表現、すなわち一つ一つ個別に表現することも出来るが、記憶は局所ではなく、総体的に入っているというのが谷氏らの考え方なので、内部スイッチが切り替わることで状態を切り替えるという方法を選んだ。

これは力学系からの発想だ。力学系はパラメーターを変えると周期運動になったり、カオスになったりする。それと同じようにパラメーター・スイッチングすることを脳はやっているのかもしれないと考えたのだという。パラメータは外から与えるが、内部のシナプスの重みを変えてやることで、学習で獲得させることができる。適応の過程でパラメータも探させる。要するに学習で獲得されるパラメーターを変えることで運動パターンが変わるのである。

あるセンサー情報のパターンが来たとする。例えば「0.2、0.8」と入れると、こういうパターンに出くわすんだなとシステムは予測する。だが実際には誤差が出る。誤差が出ると、それを逆伝播させて、パラメーターサーチをさせる。そうすると別のパターンが見つかる。これがリグレッション/リコグニッションだと谷氏は語る。予測すると、あたるか外れるかは別として、ともかく結果が必ず存在する。予測と結果を照らし合わせる、それがリグレッション/リコグニッションだ。

「いま」、この瞬間の時間というものがあるとする。いっぽう、過去には「こうだろう」と思っていたとする。予測と結果がずれた場合には、想定したことと異なるわけだから、リグレッションでPBを変更する。そして、新たなPBに基づいて将来のイメージをつくっていく。ということをロボットに実行させる。

このような神経回路を使って、谷氏はヒューマノイドロボットに対して、2種類の遊びを教える実験を行った。ロボットは、両手を使ってボールを操ることができる。まず一つ目の遊びは、それぞれの腕でボールをテーブル上で転がして、あっちにやったりこっちにやったりする。遊びをしていると、神経回路のなかのシナプスが変わって行き、PBファクターを覚えていく。

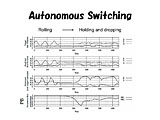

|

| 自律的な行動のスイッチ |

そこに、もう一つの遊びを加える。ボールを両手で取って、持ち上げて、落とすという遊びだ。すると、PBは自己組織化によって変更される。この場合、モーターとは腕の角度がどう変化するかであり、センサー入力情報はボールの見えである。RNNPBは常に状態をセンサー入力に応じて予測している。ズレが出てくると、PBの値はできるだけ観測と予測のエラーが少なくするように変わっていく。エラーが最小になるように働くのだ。PBは、環境入力と自己の予測の内部状態のずれを表現しているとも言える。予測していることが変化するとPBの値も変わる。そして別の行動に移っていく。

これは非常に単純なモデルである。だが、このような単純なモデルのレベルであっても、記憶は相互干渉するのだという。予測が合っており、記憶と同じなら同じで良い。いっぽう、違いがあったらその違いを構造化する。そのような過程を繰り返すことによって、記憶間の意味が出来るのではないかと考えているという。

脳においては、前頭葉にPBのようなものがあり、トップダウンで運動指令が発生すると、各部位がそれぞれのことを予測し、エラーが出てくるとエラー最小にするためPBの値が変わる。こうして、エラーを通しての環境との相互作用によって、運動自体も変わってくるのではないかと考えていると語った。

このほか、ロボットが人間の動きを見て自分の動きを変化させる実験も紹介した。人間が体操のような動きを行い、ロボットにそれを観察させる。そのときに最初はロボットの腕を直接持って、動きを教えてやる。そうすることでロボットは、センサーとモーターの時系列データを学習し、予測できるようになる。このときのPBの値を見ると、データがチャンク(ひとかたまり)を構成し、切り替わってくることがわかる。入力データは連続的だが、それがチャンクを構成するのである。

●「半分くらい予測できるロボット」でないと付き合えない?

|

| イミテーションゲーム |

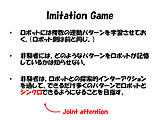

いっぽう、これでは相互作用とはいえない。人間からロボットに働きかけているだけだからだ。谷氏らはロボットから人間に働きかけることはできないかと考え、「イミテーションゲーム」を行なった。まずロボットに対し4種類の運動パターンをトレーニングする。被験者は、ロボットがどういうパターンで運動しているのかを、ロボットとの相互作用を通して探し出す、というものだ。ロボットは人間の動きに反応して体操動作を実行するので、人間側がロボットの前で動作しながらどんなパターンを学習しているのか探るのである。1時間くらいで全部見つけてくださいといったところ、かなりがんばらないとできなかった。「途中のふわふわした両者の関係が面白かった」と谷氏は当時を振り返った。

あるときにはロボットと人間の運動パターンがシンクロし、またブレイクする。あるパターンではたまたまシンクロできるが、そのうち別のパターンが出る。被験者はロボットの記憶パターンについて自信がないため、ズレてしまう。一度、被験者の運動パターンがずれていくと、いくらやっても合わないときもある。まずは、自分が動いてロボットの動きを引き込ませ、次にロボットの動きに自分が合わせるようにするのが基本なのだが、それも必ずしもうまくいかないのである。

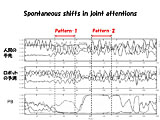

|

| 自発的なPBの変化 |

ロボットは、人間の動きを見てPBを変えていく。そうすると非定常なパターンがでてくる。こうして、被験者がゆらぎ、パターンが合わなくなり、そうするとロボットの内部状態もゆらぎ、また被験者がゆらいでしまうという関係が生まれる。1時間与えると、だいたい25分くらいはこういう状態になったという。そして、そのときにはあたかもロボットに自由意志があるように感じたと語る被験者がいたそうだ。

一番最初は、ロボットの動きは全く予想できない。半分くらい予測できて、半分くらいズレたところ。そこに意志があるように感じたという。いっぽう、完全に予測できるとただの機械にしか思えなくなる。これは人間に、他者の心の状態を類推する「心の理論」があるからではないかと考えられる。相手のことを認識できるためには、ある程度予測できるけど、予測できないところもないといけなくて、予測できなくてもパニックにならない状態というのが大事なのだと言う。「予測できなくてもかまわない」という心理状態がメタなレベルで存在している状態が重要なのだという。谷氏は「予測できないことがないと付き合えるロボットにはならないと気がついた研究でした」と語った。

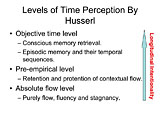

●時間の問題 連続的な情報流から離散的なイベントへ

「自己を参照する自己」に関しては、フッサールの現象学を引いて紹介した。現象学とは自分の経験からすべてが始まり、それをどう説明するかが問題だと考える学問だ。たとえば主観的なセンサー-モーター情報のフローから、主観的な時間、さらに客観的な時間を知覚できるのはどうしてだろうか。別の言い方をすると、時間は「流れている」ように感じる。同時に我々は、洗面所にいって、ご飯を食べて、という「イベントの繋がり」としても時間を捉える。一つ一つのイベントはオブジェクトとして操作可能だ。つまり、「語ろう」とするときには、イベント単位にして、それの繋がりで説明することが多い。では、どうすればセンサー-モーター情報のフローから、イベントを切り出して行くのか。

谷氏は、この問題に接したときに、これはロボットエンジニアが考えていることと同じだ、と思ったという。リアルなセンサー-モーターのフローから始まる情報が、いかにイベント化するのか。これは、連続したデータから、どうやって記号列が出てくるのかという問題とまったく同じであり「現象学はすごいな」と思ったという。物理的な時間ではなく、現象学的な、「語れる自己」の「イベントの連鎖」として「自己」がある、それは世の中の大問題の一つだという。

|

| フッサールによる時間の捉え方 |

フッサール自身は、時間にはレベルがあると述べている。時間には流れるところと淀んでいるところがあると述べているようなところには、いかにも力学的なものを感じたという。また、たとえば「ドミソ」と音が聞こえているときのことを考えると、「ミ」の音を聞いているときには「ド」の余韻があるし、「ソ」を予感している。ここには過去の履歴によるオートマチックな予測がある。最終的には意識的に再生できるものを表現する時間がある。このようなレベルを彼は「縦の志向性」と呼んでおり、谷氏は「これはロボットそのものだなと思った」。谷氏自身も、脳科学やロボットの立場で、どうやって連続的なものが分節化されてオブジェクトになっていくかに興味を持っていたからだ。

たとえば「現在」というのは、ある広がりを持っていると考えられるが、ではどこで切れているのだろうか。「ドミソ」の音の話では、「ド」の音を聞いたというちょっと前のイメージは、再表現できるような意識的な記憶にはなっていないものだ。だがある時点で、過ぎ去った過去が、過去のイメージとして定着するのだと考えられる。そのような仕組みはRNNで表現できるのではないかと考えたのだという。

RNNはオートマチックにちょっと前の状態を入力として受け、次の状態を予測するからだ。内部状態のコンテキストユニットも持っている。過去の履歴も持っている。過去のコンテキストを溜め込みながら次のことを常に予測しているわけだ。だが、予測がまるっきりできなくなると、PBの値が離散的に変わる。こうして、世界の変化に応じて時間が分節化されるのではないか、と谷氏らは考えた。

|

| PBによるセンサー-モーター情報の分節化 |

また、我々の運動は、基本的な「運動プリミティブ」の組み合わせで組み立てられているという考え方がある。谷氏らはそれを実現するために運動プリミティブをRNNに学習させて、もう一つのRNNにPBの切り替えを学習させてやり、ふたつのRNNを組み合わせて実験を行なった。ボトムアップに加えてトップダウンでも予測が起こり、両者がやりとりする。その間に自由意志の問題のようなものがあるのではないかと考えているからだ。すると運動の分節化が起きた。これがオブジェクト化された主観的な経験なのではないかと谷氏は考えているという。どういうことかというと、色々な組み合わせを教えることで、いろんな場面で、時には同じようなパターンが出てくる。そうすると、予測エラーが出てくるところまでは一つのチャンクにすることがベターな戦略だ。これを繰り返すことでチャンクができていく。シーケンスのなかに「切れ目」が生まれるためには、予測できないことが大切であり、そのためには基本要素がさまざまなかたちで組み合わさった、繰り返し体験が重要だという。

また、いろいろな経験の中から運動プリミティブを見つけ、それを使って言葉で説明する、それが「エピソード」であり、エピソードはいわば経験したことのキャッシュで、再構成されたものだという。PTSDのトラウマ体験の治療の一つに、体験を言語化して語るというものがある。それも、言語化することによって、まだ分節化されていない生々しい体験が抽象化されて細かい部分が抜け落ちていき、他のもので置き換えられるラベル化されることになるのではないかと谷氏は考えているそうだ。

|

| 過去の反省と未来の予測のあいだ |

谷氏は、物体にアプローチするアームロボットを使って実験を行なった結果を示した。トップダウン側とボトムアップ側のRNNがそれぞれの予測をぶつけあううちに、おさまりがついていく。二つの予測器が予測することで、互いに影響を与える、その部分が非常に大事だという。これもまた「なだれ現象」と同じような、臨界的な状況ができてきており、自己参照になっているのではないかと述べた。環境が変動し、予測と一致しなくなったときには、両方が互いに頼ることになるので、、本当の意味での自己参照が出てくる。逆に、予測どおりになり、まったりと落ち着いているところは自己参照に入ってないのではないかという。

●「死」が存在を固有のものにする

|

| 谷淳氏 |

谷氏は、自律的な働き(オートノミー)は、参照が互いに噛み合ないところで起きてくる、それはハイデガーの話とも繋がると続けた。ハイデガーは人間を「現存在(Da-sein)」と呼び、関係性でモノは存在できると言った。他人との関係で、相対化されるなかで、自己も在る。さらにハイデガーは、相対的な存在に甘んじてはいけないとも言っており、社会に完全に引き込まれた状態では個は存在してないのと同じだと述べているという。

相対化できないもの、それは「死」だ。「死」はどんな存在にとってもユニークなものだ。「死」を受け入れるためには自分自身がユニークであることを受け入れなければならない。「死」があるからこそユニークな存在でなければならないとも言える。過去は反省であり、死へ向かう予測もそこへ向かっている。

谷氏は、「僕のロボットの話が直接そこには繋がらないんだけど」と断りながら、何かにむかって予測する、そして過去を反省する。それによって不安定化する。それによって、行動の軌跡がユニークになり、固有の自己が存在する。意識を持つロボットには固有性がないといけない。コヒーレンスを壊すものが必要であり、そこにオートノミーや自己が存在するのではないかと思っている、と講演を締めくくった。

2009/12/17 18:52