「コンピュータビジョン・拡張現実感に関する普通じゃない勉強会2.0」レポート

~ハッカーや研究者、メディア・アーティストが考える拡張現実の次に来るものとは?

|

| オープニング&スペシャルトークセッションの様子 |

VR(Virtual Reality)やAR(Augmented Reality:拡張現実感。強化現実感や複合現実感といった言い方もある)を題材に、創意工夫と冗談技術と「作ってみた」精神の発表会「コンピュータビジョン・拡張現実感に関する普通じゃない勉強会2.0」が、20日(土)に明治大学生田校舎にて開催された。オープニング&スペシャルトークセッション「R2:Real×Reality」を中心に、9つのテーマセッションと4つのテクニカルセッションが行なわれる、丸一日に及ぶ規模の大きな発表会である。目の付け所が非常に個性的で、技術力などに感心させられると同時に、趣味丸出し(笑)のプレゼンも多く、なかなか笑える内容となった。オープニング&スペシャルトークセッション「R2:Real×Reality」を中心にその模様をお届けする。

●「コンピュータビジョン・拡張現実感に関する普通じゃない勉強会」とは?

同勉強会の幹事を務めるのは、主にC言語でのプログラミングを主軸に、拡張現実感や音声認識、画像処理など、さまざまなテーマを工学系大学生や高専生などをメインターゲットに情報発信しているサイト「工学ナビ」を運営する、独立行政法人科学技術振興機構のERATO(戦略的創造研究推進事業)・五十嵐デザインインタフェースプロジェクト研究員の橋本直(はしもと・すなお)氏。同分野においては、「3Dキャラクターが現実世界に誕生! ARToolKit拡張現実感プログラミング入門」(アスキー・メディアワークス)の著者として知られる人物だ。橋本氏は、この勉強会を、「プロ・アマ問わずに、みんなで楽しくネタ発表や技術談義を行なえる場を作ろう!」として、昨年夏に第1回を開催した。ARの学術的なポジションにいる研究者や専門家と、実際に自分の手で作って動画サイトに投稿している趣味の領域のアマチュアたちを結びつけようという試みである。

今回のテーマは、「VR→AR→?R」。2007年頃からARToolKitを使用したアマチュアのAR関連作品が、動画サイトなどに多数が投稿されて人気を博したのだが、単純にマーカの上にCGを表示させるだけのスタイルはほぼ出尽くした感じで、飽きつつあるという状況。そろそろその次をということから、発表者に自分なりの「?R」をプレゼンしてもらい、みんなで次を探そう・作ろうというわけである。テーマセッションでは、この「?」に何らかのアルファベットを入れた形で、実際に作成したり開発中だったりする機器やプログラム、またはコンセプトなど9つが発表された。また今回は、テクニカルセッションが設けられた点も新しく、これは、これからARをやってみたいという人たちのために、実践的な技術ノウハウを披露するというもので、4つの発表があった。テーマセッションにしろテクニカルセッションにしろ、どの発表者も「なければ自分で作ってしまおう」という、得意分野はそれぞれ異なるが技術と知識を持ったハッカー魂あふれる人たちばかりで、取材していて実に面白かった。

ちなみに、今回も当初は比較的小さめの部屋で、数十人規模の参加者を想定していたそうだが(第1回は50人弱)、あれよあれよという間に参加者が増え、最終的には200名強に。第2校舎の5階にある2005号室という、プレゼン用スクリーンが2つある、非常に大きな講義室が利用された。

●オープニング&スペシャルトークセッション

まずは、オープニング&スペシャルトークセッションの「R2:Real×Reality」からスタート。オーガナイザを橋本氏と、大学で助教を勤めた経験もあり、現在は橋本氏の同僚である福地健太郎氏が担当してスタートした。次の?Rを発表してもらう前に、まずはリアル(現実)とは何か? リアリティ(現実感)とは何か? ということを確認しておこうということである。そこで登壇したのが、事前には伏せられていた、スペシャルゲストの2人。慶應義塾大学大学院メディアデザイン研究科教授の稲見昌彦氏と、メディア・アーティストの八谷和彦氏だ。

|  |

| 慶應義塾大学大学院メディアデザイン研究科教授の稲見昌彦氏 | メディア・アーティストの八谷和彦氏 |

|  |

| 同勉強会幹事の橋本直氏 | 橋本氏とともにオーガナイザを務めた福地健太郎氏 |

稲見氏は、SFアニメ「攻殻機動隊」に出てくる技術の1つである、「熱光学迷彩」の研究者として紹介されることが多い人物。実際には、劇中の熱光学迷彩とは異なり、AR技術の一種であり、ある特定の角度から見た場合に限って背後の景色が透けているように見せることもできるというもの。とはいえ、記者も以前に取材させてもらった経験があるのだが、本当に透き通ったように見える(劇中のように、ほぼ完全に透明というのはさすがに無理で、半透明というぐらい)。本来は、車内のウィンドウ以外の部分などに、その技術を使用して外部の映像をウィンドウ越しに見える実視域と寸分のズレもなく投影し、まるでクルマのドアやダッシュボードなどが透き通ったかのようにし、死角をなくして安全性を高めるという使用などを想定。こうしたARに関するシステム全般を研究しているほか、触覚インターフェイスや感覚ハックなど、五感に関わる新しいユーザーインターフェイスを研究していることで国内外に知られている。

もう1人のゲストの八谷和彦氏は、メールソフトとして一時代を築いた「ポストペット」の開発者として知られる人物だ。現在、同ソフト関連のソフトウェア開発とディレクションを行なう企業「ペットワークス」の代表であると同時に、メディア・アーティスト、デバイス・アーティストとして活躍中だ。作品としては、「視聴覚交換マシン」やジェットエンジン付きスケートボード「エアボード」など。宮崎駿監督作品の「風の谷のナウシカ」に出てくる個人用の飛行システム「メーヴェ」の実機を作ろうというプロジェクト「オープンスカイ」なども手がけている。

スペシャルトークは、まずは稲見氏の特別講義からスタート。蛇足かも知れないが、まず簡単にVRとARの違いを説明しておくと、VRは完全にCGで表現された、仮想現実(感)を示す。それに対し、ARは現実を拡張するということから、実視映像にCGを加えて、よりその場の状況を把握しやすくするといった形だ。例えば、目標とする物体や建物までの距離や方位、施設内や地下など直視できない場所の人や物体の位置やデータなどを表示したり、肉眼では見られない各種電磁波、磁場、音場などをCGで表現したりといった具合である。マンガ「ドラゴンボール」の中で、サイヤ人が使用しているヘッドマウントディスプレイの「スカウター」もAR機器の一種としてよく例に出されるし、近年だとSFアニメ「電脳コイル」の「電脳メガネ」もAR機器として有名である。何はともあれ、肉眼では把握しにくいものを、各種センサーでとらえ、それを数値やCGで実視映像に重ね合わせて表示することで、周囲の状況や目標物の情報などをよりわかりやすくする技術のことを、ARと呼んでいるわけだ。広い意味ではVR技術の一種であるが、近年、CGオンリーのVRはどこまでいっても現実には近づけないという限界や、用途が限定されてきている実情があり、現実をより便利にできる利便性の高いARにシフトしてきている。

特別講義は、お笑いタレントの爆笑問題の2人が、稲見教授を訪れたテレビ番組の1シーンからスタート。さらに、AR(VRのでもある)の元祖といわれるヘッドマウントディスプレイ型の3次元ディスプレイシステム「See-Through HMD」(1968年製)とそれを開発した米ユタ大のイヴァン・サザーランド氏が紹介され、続いて稲見氏自身が最初に開発した1998年製の初代「Head-Mounted Projector」(HMP)から最新の「HMP-V」(慶應大学館研究室)まで、次々と紹介されていく。ちなみに、初代HMPは重さが5kgもあったそうだ。また、ARという言葉は、10年ぐらい前、世紀の変わり目の頃から使われ出したということである。

|  |  |

| 元祖VR&ARシステムの「See-Through HMD」 | 稲見氏の元祖ARシステム「Head-Mounted Projector」 | 稲見氏の最新ARシステム「HMP-V」 |

そのあと、稲見氏がまず話し出したのは、ARのマスコミでの紹介において、「拡張現実」と表現されることが多いが、それには違和感を覚えるということ。拡張現実感と、「感」をつけることが正しいとした。なぜなら、リアルとは物理世界のことであり、リアリティとは我々が感じている現実のことだからである。よって、ARはあくまでも我々の脳が感じて初めて認識できる、拡張された現実感であると指摘した。ただ、リアルに表現したからといって、必ずしも人がリアルに感じるわけではないという話も。つまり、ウソの表現の方が、人はリアリティを感じるというわけだ。

講義が終わったあとは、ウソの表現にリアリティを感じるという、「本物よりも本物らしい」という話からまずはスタート。今度は八谷氏がマイクを持ち、ポストペットのリアルさは、単純に3DCGだからというものではなく、メールの到達速度など、そのほかの要素に寄るところが大きいという話や、幽霊は現実の存在ではないのに(実際にいる・いないは別として)、リアリティ(現実感)だけはなぜかあるといった話がなされた(八谷氏は幽霊、UFOは信じないとのこと)。八谷氏は、リアリティは脳の中で作られているものだから、それがリアルに存在するかどうかは関係ないという。ちなみに、リアル・メーヴェの開発に関しては、先に劇中でのメーヴェの飛行シーンを多くの人が観ていて既に空を飛ぶリアリティを感じているので、逆にそこからリアルを作ればいいという逆の発想から作っているそうである。

また、「人魚の窓」という作品を作った経験から、そこに本当にいるのに我々には見えていないだけ、というものを扱うのが、ARで一番面白いスタイルなのではないかとも語った。人魚の窓は、一見すると何も映らない窓のようなモニタ(実際には映像が流されているのだが、ノイズを利用して人間の目には見えないようにしている)なのだが、間接的にもう1枚の鑑に映してみると、窓の中に17歳の女の子が演じた人魚が見えるという具合。八谷氏自身はかわいらしいイメージで作ったそうだが、本気で怖がられる(肉眼で見えないのに、鏡に反射させた時だけ女の子が現れ、しかも目が合うというのが、かなりリアリティのある幽霊っぽい)のが欠点、としていた。そのほか、2人1組で利用する視覚交換マシンも紹介された。視覚と聴覚が相手のものに入れ替わってしまうというもので、「キスすると面白いんです。自分の顔が迫ってきますので(笑)」。このキスはアンケートによると、体験していない人には想像できないほど結構感動的らしい。ちなみに、男女間で利用すれば、キス以上の行為(笑)でもちゃんと使えるように作っているそうである。

|  |

| オープンスカイプロジェクトで開発中のリアル・メーヴェ | 人魚の窓。上側の窓は肉眼で見ると何も見えないが、鑑に反射させると…… |

|  |

| このように女の子が映っているのが見える。肉眼では見えないのに鑑には映るという、ほとんど幽霊 | 視覚交換マシンを装着している人たちの様子。大人も子供もとても楽しそうにしていた |

続いては、稲見氏の作品に戻って、触覚系インターフェイスが紹介された。グラスの中で、水の下に沈んでいる油の表面を触ってみるデバイスや、メスの先端にセンサーを備えさせることで、黄身を一切傷つけずにゆでたまごの白身だけを切り開いたりするデバイスも。さらに、会場中にアブないと衝撃を与えたのが、大阪大学の研究者など4名で共同研究している「平衡感覚のAR」という実験。ここで使われたシステムは、まず被験者の両耳の後ろの辺りにそれぞれ電気パッドをくっつけ、電気を流すというもの。この位置に流すと、人は重力感覚が狂って、歩いていると電気が流れている側に身体がフラフラと傾いていってしまうのである。まさに「人間コントローラー」とでもいうべき、驚異の感覚ハック系デバイスである。記者は以前、別の媒体でこれらの取材経験があるのだが、平衡感覚のARに関しては悪用されると非常に怖いという気持ちを抱いた。会場も、ブラックなゆえに笑ってしまうという雰囲気。まさに鉄人28号ではないが、「技術は使う人次第」というわけだ。

|  |  |

| 水の下の油を突っつき、その感触を確かめられる触覚インターフェイスのデモのワンカット | 触覚センサー付きのメスで、黄身には一切傷を付けずに白身だけを切り分けたところ | 感覚ハックのデモの様子。赤い服の被験者が、酔っぱらいとはまた違った感じで左右に不自然にフラフラする |

ちなみに八谷氏は、聴覚や重力感覚は意外と簡単にハックできるという。かつて行なわれた「ガンダム展」において、たまたま稲見氏の人間コントローラーと同じ原理のシステムを「サイコ・コミュニケーター」と称して、2人1組で体験してもらったそうである。1人の目の動きをとらえ、もう1人を左右に操るというもので、2人の間にサイコミュが働いていると思えるような仕組みである。八谷氏は「フラナガン・エージェンシー」のニュータイプテクノロジーラボ、通称NTTラボ(笑)の研究者という設定で、その通りに刺繍を施した白衣を着て(笑)、ジオン公国内で民間人からニュータイプを選抜する試験を行なっているという見立てで来場者に体験してもらったそうだ。

その後、福地氏が非常に感動したという、ARToolKitを利用した、ハンドガン型の距離センサーのAR映像が紹介された。停滞感があったが、まだまだARToolKitを利用したAR映像は作れるとして、福地氏だけでなく、稲見氏も製作者の指名手配(笑)をかけたほどだそうで、実は稲見氏の知り合いということだったらしい。それから、ARデバイスと映像を作るためのソフトやハードの一覧も紹介された。解説書なども揃ってきており、初心者でも参入しやすい状況になってきているそうである。そのリストを下記にまとめておくので、興味を持った人は、ぜひ挑戦してみてほしい。

【ソフトウェア系】

OpenCV:画像処理ライブラリ

ARToolKit、ARTag:マーカ方式AR

PTAM:マーカレスAR

Processing:メディアアート開発環境

Bullet:物理エンジン

【ハードウェア系】

Arduino、Gainer:初心者でも簡単に扱えるマイコン

●シークレットゲストが登場! 「電脳メガネ」の……

また、事前登録の際に実施された参加者アンケートも発表され、学生が大半を占めるかと思われたら、意外と社会人も多く、福地氏は「俺もやってていいんだ(笑)」と元気づけられたという。そして、面白かったアンケートが、「『電脳コイル』の世界が実現するまでにあと何年?」というもの。『電脳コイル』とは、2007年5月から12月までNHK教育テレビにて全26話が放送された作品だ。第13回アニメーション神戸賞「個人賞」に始まり、東京国際アニメフェア2008 第7回東京アニメアワード「テレビ部門優秀賞」、平成19年度第11回文化庁メディア芸術祭「アニメーション部門優秀賞」、第47回日本SF大会第39回星雲賞「メディア部門」、第29回日本SF大賞などを受賞した、非常に評価の高い作品である。2020年代の子供たちの日常生活を描いており、SFでありながら現在と変わらない雰囲気が好評を得た理由のようだ。子供たちの必須アイテム「電脳メガネ」(今のニンテンドーDSやPSPなどが目じゃないぐらい、持っていないと話にならないぐらい大流行している)がARデバイス(正確にはウェアラブルコンピュータ)ということで、アンケートでピックアップされたようだ。アンケートは「10年後」がダントツに多い結果となっている。

そして福地氏が突然、「この数値を見て、磯監督、どう思われますか?」と最前列の予約席に座っていた人物にマイクを向けると、なんとそこには「電脳メガネ」の原作者兼監督の磯光雄氏の姿が! 記者ですら事前に知らされていなかったシークレットの中のシークレットゲストだったため、会場も最初は冗談かと思っていたほど。しかし、本人とわかって拍手喝采となった。電脳メガネが出回ったのは、主人公の小学校6年生の少女・小此木優子(ヤサコ)が生まれた2014年だという。ちなみに、劇中の時代は正確には2026年というわけである。電脳メガネ発売まで、あと10年もない。任天堂やSCEが、DSやPSPの後継の次々世代型携帯(ウェアラブル)ゲーム機として発売するのはありなのではないかと思うのだが、いかがだろうか。

|  |

| 「電脳コイル」の世界が実現するまであと何年かかるかというアンケート結果 | 「電脳コイル」の原作者兼監督の磯光雄氏 |

なお、磯監督によれば、作品で語られていない設定がやたらと細かくまとめられているそうで、もともとは国土交通省が走行中の自動車の車種などのデータを通信で取得することなどを目的に開発したシステムが、インフラとして整備されているということで、電脳メガネはそれを足がかりにしているらしい。国家プロジェクトにぶら下がる形で安価に提供しているのだそうだ。磯監督は、「今はそんなシステムはないので、ぜひ皆さんにがんばってもらって、2014年に誰かが『できました』とぜひ持ってきてもらって(笑)。信じていますので、がんばってください」とした。ちなみに磯監督は、実際に実現するまでに何年かかるかというところは、「2014年なので、あと5年じゃないですか(笑)。待ってますんで」とコメント。そこで時間となり、スペシャルトークセッションは惜しまれつつも終了となった。

●テーマセッションは9つ、テクニカルセッションは4つのプレゼンを実施

スペシャルトークセッション終了で1回休憩を挟み、続いてはテーマセッションがスタート。この日は、テーマとテクニカルの両セッションと合わせて14のプレゼンが行なわれたが、1つ1つの詳細なフォローはスペース的に厳しいため、中でも面白かった2点をまず紹介させていただく。残りの12のプレゼンについては、概要紹介にとどめさせていただいた。発表者自身やプロジェクトのホームページがある場合は、そちらへのリンクも張ったので、興味のある方はぜひ訪ねてみてほしい。テーマセッションとテクニカルセッションのタイトルは以下の通り。カッコ内は発表者名だ。

【テーマセッション】

・WIMPAR:実世界でGUIを使いたい(aimino氏)

・SR:2次元に入ってみた(chakki氏)

・AR:全周囲裸眼立体ディスプレイを用いた2Dループゲームの提案(吉田匠氏)

・PR:拡張現実戦争-見えざる星の海、東京へ(akio0911氏)

・JR:モバイルデバイスを空間にしてしまおう(niryuu氏)

・XR:AR Cooking 素材の組み合わせは∞(無限大)?(大江貴志氏)

・πR:盛り上がるディスプレイ「photoelasticTouch」(佐藤俊樹氏、福地健太郎氏)

・S/N-R ToolKit:ARを用いた身体感覚改造レッスン-いつか出会う「あっち」の世界の嫁のために-(津坂真有さん)

・∀R:生と死を超えるリアリティ(宮下芳明氏)

【テクニカルセッション】

・SpaceNavigatorをGLUTに(まお氏)

・多数のセンサ、クリエーターと技術者を結ぶオープンソースプロジェクトKAKEHASHI(ksasao氏)

・touchBox:マルチタッチできる箱を作ってみた(arc@dmz)

・OpenCVをさらに簡単にするライブラリ~車輪の再発明に終止符なるか~(橋本直氏)

●最も会場を沸かしたのは「πR:盛り上がるディスプレイ『photoelasticTouch』」

それでは、最も面白かった発表から紹介しよう。とにかく会場が沸きまくったのが、佐藤俊樹氏と、スペシャルトークセッションでモデレータを務めた福地氏による7番目のプレゼン「πR:盛り上がるディスプレイ『photoelasticTouch(フォトエラスティックタッチ)』」だ。その発表までに、人類の宿願(?)ということで、どうにかして2次元世界に入り込みたいという思いを結晶させた技術が2点ほど紹介されたのだが、福地氏曰く「志が低い!」。自身の発表はその逆で、2次元の住人を3次元世界に引っ張り出そうという偉大な(笑)コンセプトだ。

それをどう実現するかというと、東急ハンズなどで売られている透明ゲルを利用した柔らかなインターフェイスが重要となる。これにより、平面的で硬い(モニタ上の)映像を柔らかく立体的にするのである。原理としては、ゲル状なので、触れば当然形状が変化し、下のモニタからの光も影響を受ける。通常ならゲルを透過してきた光は、カメラの前に偏向フィルタを設けることでシャットアウトが可能。ただし、形状が変化した部分を通り抜けてきた光はフィルタを透過するので、それをカメラでとらえることで、変形した領域の様子から、位置、形状、触った強さ、押した方向などがわかるというわけである。

ポイントは、マーカレスで認識可能なのでモニタの映像を妨げないし、素材そのままなのでどのような形状にも加工が容易という点だが、やはり最大の魅力(?)は、その柔らかさで、人肌に近く、触って気持ちいいということだろう(笑)。モニタ上の2次元の嫁(笑)の映像上に、体型に合わせたゲルで作成したphotoelasticTouchを貼り付けることで、見事3次元世界に引っ張り出すことに成功というわけだ。なお、フォトエ「ロ」スティックタッチ(笑)ではないので、間違いないように、と佐藤氏。

|  |  |

| photoelasticTouchの研究をしている佐藤俊樹氏 | 原理。ゲルを透過したモニタからの光は、フィルタを抜けてカメラまで届くという仕組みだ | 透明ゲルは東急ハンズなどで売られているので、購入は容易 |

|  | |

| 少しわかりにくいが、photoelasticTouchを押して、下からの光が透過しているのがわかる様子 | 2次元の嫁の体型に合わせて貼り付けたところ |

ちなみに後半は、「ご家庭での調理の仕方」として、ゼラチンを使用した透明ゲルの作成法を披露。エプロンをつけた福地氏が、キューピー3分間クッキングのテーマとともに後を引き継ぎ、レシピを公開、実際に調理して見せた。レシピは、粉ゼラチン15g、熱湯180cc、水適量、サラダ油少々。粉ゼラチンを水でふやかしておき、熱湯を注いでよく混ぜる。ダマにならないようにするのが注意点だ。そして型に薄く油を引き、溶かしたゼラチンを嫁の体型の型(それを作るのがまた大変そうだが)に流し込めば、インターフェイスの完成!

|  |  |

| 今度は発表者(というか料理の先生?)として、福地氏が再登場。エプロンを腰に巻いている | ざっと嫁の身体に合わせてゼラチンを貼り付けたところ | 触り心地はグー(笑)。これで2次元の嫁と肉体的接触を持てるというわけだ |

●まずはイメージから! 「PR:拡張現実戦争-見えざる星の海、東京へ」

4番目に発表された「PR:拡張現実戦争-見えざる星の海、東京へ」も、なかなか会場を沸かせていた。また、プレゼンを行なったakio0911氏は、この日のベストドレッサー賞(?)ともいうべきコスプレスタイルで登場。黒のフードを頭からすっぽり被り、表情はほとんどうかがえないという、見事な「謎の人物」ぶりだ。それにより、某6部構成(後半の4~6作目が先に作られた)のハリウッドの大作SF映画の熱烈なファンということが即刻発覚した。ちなみに、なんでまたコスプレまでしてきたかというと、まずはイメージが大事だからだそうである。

akio0911氏は、Hacker's Cafeというグループに所属するのだが、今回はそこで開発が進められているARを利用したコンテンツが紹介された。都内全域を仮想的な銀河連邦に見立てた、「拡張現実版宇宙戦争ゲーム」である。根底に、「街中で宇宙戦争をしたい! 都庁や東京タワーなどを破壊したい!」という熱い(?)思いがあるようで、イメージとしては、秋葉原や新宿など23区の上空を宇宙戦艦や戦闘機などが飛び、都庁や東京タワーなどを破壊する様子をARで表現するという。また、本作はあくまでも同人のARソーシャル(ネットワーク)ゲームであり、技術的・設定的な整合性は捨てて、「面白ければいいじゃない!!」という心意気で制作していくとした。ユーザー端末として、iphone 3G Sが使用され、ゲームルールは1ゲーム24時間で、ゲーム終了時のポイントで競う仕組みである。街中のデジタルサイネージなども考えられており、参加ユーザー以外でも戦況を確認できるようなWebサイトやブログなども用意するという。部屋に引きこもりがちな現在のネットゲームとは異なり、外に出て楽しめる仕組みも面白いのではないだろうか。

|  |  |

| akio0911氏。ス○ー・○ォーズのシ○の一員のような出で立ちでプレゼンをした | ハリウッド映画風に、まずはイメージ映像から | システムの模式図。Webカメラや地磁気センサーなども使用するらしい |

●そのほか7つのテーマセッション

続いては、残り7つのテーマセッションの概要を紹介。まずは、aimino氏の「WIMPAR:実世界でGUIを使いたい」からだ。こちらは実世界のさまざまな物を、PC上のファイルのように扱うことを目的としているコンセプトである。今回製作されたデモでは、PCの画面上でLEDの発光・消灯、発色の種類の変更を、ドラッグ&ドロップなどを駆使して披露して見せた。まだまだ途上のコンセプトという。WIMPARとは、WIMP(Window Icon Menu Pointing Deviceを指す言葉)にARをつけたということだ。

|  |  |

| aimino氏。スペシャルトークセッションの後を受けて、プレゼンのトップバッターを担当した | LEDの点灯を画面上でコントロールしているところ | 仕組み。ArduinoとつながったLEDとWebカメラがPCにつながっている |

続いてのchakki氏の「SR:2次元に入ってみた」は、人が2次元世界に入るというコンセプト。chakki氏曰く「人類の悲願」(笑)というユーザーインターフェイスおよび物理エンジン系の技術が紹介された。要は、モニタ上の物体や人などを、直接触るかのごとく操作できる仕組みというわけだ。デモでは、某電脳歌姫を画面内の手が押したり持ち上げたりする様子を披露。CGの女の子をいいようにできる(笑)というわけだ。SRのSは、「二次(元│現)実」という意味の「Second」と、視覚にシースルー表示をした場合にあたかも実際に触っているような感覚で操作できるという意味で「See-through」からも取られているそうである。

|  |  |

| chakki氏。2次元世界に入ることは人類の悲願と断言する人物。理解できる(笑) | 脂肪のような塊を2つ並べて、ゆっくりとだが揉んでみるなんて使い方ももちろんOKだそうだ | バーチャル物体の動きがリアルであればあるほど、実際に触れていないのに現実感が強くなるという |

3番目は、吉田匠氏による「AR:全周囲裸眼立体ディスプレイを用いた2Dループゲームの提案」。ARはAnti Realityの略で、反現実(感)。現実から、立体感、色、時間、音など、「現実(感)を構成する要素」を取り除いたらどうなるかというもので、現実(感)の対義語の非現実(感)とはまた異なる。現実+α=拡張現実なら、現実-α=反現実と考えられ、現実≒バーチャルとすれば、バーチャル-α≒反現実とした。吉田氏の所属する研究室では、稲見氏も開発に関わっている全周囲裸眼立体ディスプレイ「TWISTER」(円筒形をしており、視聴者は中央に立って周囲を囲まれる形で映像を見る)が設置されている。それを利用することでまずバーチャル環境とし、そこから立体感をなくし、「人類の悲願」(笑)である2次元への没入を可能としたというわけだ。この環境で製作した横スクロールシューティングゲームなどが披露され、自分が撃ったビームが流れ弾となって後方から来て撃墜される様子など、ゲームとして面白いのか面白くないのか微妙だが、場内の笑いを誘う画面が披露された。

|  |  |

| 吉田匠氏。反現実というコンセプトを核に据えたプレゼンを行なった | TWISTERによる横スクロールシューティング。青い波形のビームが自機より後ろから来ているのがわかる | 反現実を導き出すための考えの推移をまとめたプレゼン画面 |

5番目は、デバイス製作系で、niryuu氏の「JR:モバイルデバイスを空間にしてしまおう」。JRとはJointed Realityの略(ネーミングから入ったそうだ)。「デバイスの中と外の両方の空間を拡張する」というコンセプトだ。端末の外はAR、中はJRとし、端末の外と中をつなぐということだが、記者的にはちょっと難しかった。具体的なハードとしては、裏側もタッチパネルになっていて、指で画面を隠さずに操作できるモバイルデバイスを披露。以前からアイディアがあったところ、実際に同じコンセプトの「nanotouch」というデバイスを知ったこと、混雑する通勤電車の中で新聞を小さく折りたたんで読んでいるオジサンを見たことに触発されて、紙のような感覚で利用できるモバイルデバイスを目指したそうである。残念ながらぶ厚くなってしまい、紙のような感覚は出せなかったことは反省点、としている。

|  |  |

| niryuu氏。手に持っているのが、製作したモバイルデバイス | モバイルデバイスは、厚みがあることが弱点とする。niryuu氏が某動画サイトにアップした映像から | 端末の外はAR、中はJRとし、端末の外と中をつなぐという概念図 |

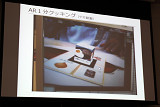

6番目は、大江貴志氏の「AR Cooking 素材の組み合わせは∞(無限大)?」。複数のマーカを組み合わせると、1つのオブジェクトが完成するというもので、その完成するオブジェクトをAR的に表現する仕組みだ。また、マーカの組み合わせ方によって、完成するオブジェクトが変化するという仕組みも有する。今回は料理を題材にしており、3つのメイン食材と1つの調味料の計4つのマーカを組み合わせ、「調理する」とオブジェクトとして料理が完成する内容とした。料理と素材の関連性を利用者の介入により直感的に示せるので、未来のおままごとセットのような、幼児向け情操教育用の教材として利用できるのではないか、という話であった。なお、XRとはeXpanded Realityの略で、「経験を拡大し、伝承するメディア」ということである。

|  |  |

| 大江貴志氏。こんなに大勢の前で発表するとは聞いていなかったようで、驚いていた | マーカのイメージコンセプト。このように組み合わせると料理ができる | AR画面。できあがる料理は立方体に描かれている |

8番目は、紅一点の津坂真有さんによる「S/N-R ToolKit:ARを用いた身体感覚改造レッスン-いつか出会う『あっち』の世界の嫁のために-」。直接的な(笑)タイトルだが、その目的のためには身体感覚の改造と仮想空間をダイレクトに受け入れることが必要である、とするコンセプトだ。要は、修練に次ぐ修練を重ねることで、数字やアルファベットなどの文字列で十分2次元の嫁をダイレクトに感じられるようになるという、実体験に基づいた話である。津坂さんは、身体ハック系メディア・アーティストおよびパフォーマーであることから、少々特殊な内容の舞台のため、猛練習を重ねてある一線を越えてこの境地に到達した経験があるのだそうだ。なお、「ダイレクトに受け入れる」というのは、文字列から嫁をイメージするというレベルより一歩進んだ(?)形で、脳内変換なしで文字列をそのままに感じ取るというものだそうだ。S/N-Rとは、Signal Noise Reality(シグナル・ノイズ・リアリティ)の略である。

|  |  |

| 津坂真有さん。女性にも関わらず、嫁ネタというギャップの激しい発表であった | 2次元世界に入る系統のコンセプトといえる | 極限に到達すれば、人間もセンサデータだけで世界を認識できるようになるらしい |

テーマセッションのトリは、会場となった明治大学の理工学部情報科学科(ディジタルコンテンツ学)で研究室を構える准教授の宮下芳明氏。ハンカチ必須の「∀R:生と死を超えるリアリティ」と題した発表が行なわれた。宮下氏は幽霊もUFOも宗教も神も信じず、死生観もテキトウだそうで、唯一全知全能の神がいるとすれば、それは某ナンバー1検索サイト(笑)という人物(それは半分冗談で、正しくは情報科学技術こそが全能と考えているそうだ)。

そんな宮下氏はおばあさんを数年前に亡くしており、それが考え方を改めるきっかけになったという。おばあさんは、買い物に出てお店へ向かう途中で急逝してしまったそうだ。宮下氏は、某「ストリートビュー」でそのルートをたどり、もしかしたらお婆さんが写っているのではと期待したが、それは叶わず、初めてGoogleが自分の思いに応えてくれなかった経験をしたのだそうだ。そうしたことがきっかけで宮下氏は、ARは現実世界に幽霊を作る技術ととらえるようになる。ただ、一般にいわれる幽霊ではない形で、誰でも本当に亡くなった人に会えるように情報科学的・技術的に「この世の拡張」をしたいとしている。なお、∀とは「すべてを含む」という意味で、この世とあの世をすべて包含した世界ということだ。

|  |  |

| 明治大学理工学部情報科学科(ディジタルコンテンツ学)准教授の宮下芳明氏 | なんかオカルティックな感じであるが、「この世の拡張」を目指すという | ∀はすべてを含むという意味を持つ。宮下氏の研究が実を結べば、この世とあの世の境界はなくなるのか? |

●4つのテクニカルセッション

まずはまお氏の「SpaceNavigatorをGLUTに」。日本でもトップクラスと自称するユーザーインターフェイスコレクター(マウスだけで300種類)のまお氏が、3DナビゲーションデバイスのSpaceNavigatorを、Windows環境下での3DCG処理のプログラミングインターフェイスのOpenGLに準拠したC言語のライブラリであるGLUT(OpenGL Utility Toolkit)で使うためのプログラム面での改造方法を披露した。

|  |

| ソースコードを変更しているところ | 実際にSpaceNavigatorを使用しているところ |

続くksasao氏の「多数のセンサ、クリエーターと技術者を結ぶオープンソースプロジェクトKAKEHASHI」は、「PR:拡張現実戦争-見えざる星の海、東京へ」のakio0911氏と同じHacker's Cafeのメンバーで、以前のゲームの「電脳スターラリー」では、AR部分(ハードウェア)を担当した。ヤサコの誕生年の2014年までに、処理速度、記憶媒体容量、通信速度の3点で電脳メガネのスペックを満たせるとしたが、「電脳スターラリー」で苦労したのがデザイン面の問題、つまりクリエーターがいないこと。そこで、クリエーター(デザイナー)と技術者(ハッカー)とのお互いの得意分野をつなぐ仕組みとして、「オープンソースプロジェクトKAKEHASHI」が考え出されたというわけだ。利用イメージは、クリエーターの場合、まず使いたいデバイスを買ってくる、次に対応するKAKEHASHI用プラグインをダウンロードする、いつもの使い慣れたツールでKAKEHASHIを利用するという具合。KAKEHASHIサーバは、デバイスつなぎ放題を管理し、高速なレスポンス、面倒な処理を隠蔽するという。現在、ベータ版が開発されており、7月1日にアップデート予定としている。

|  |  |

| ksasao氏。akio0911氏と同じHacker's Cafeに所属する | 以前のARソーシャルゲーム「電脳スターラリー」のAR装置 | 「オープンソースプロジェクトKAKEHASHI」の公式サイトの概念図(英語) |

次の「touchBox:マルチタッチできる箱を作ってみた」は、arc@dmz氏のプレゼン。いわゆる、複数カ所を触って操作できるようなマルチタッチディスプレイを、できるだけ小型化してみるというプロジェクト。ノートPC、赤外光を利用するためのアクリル製スクリーン、赤外光検知用Webカメラ、そしてプロジェクタと鏡という構成になっている。タッチしたカ所を検出する仕組みは、赤外光をアクリルパネル内で全反射させ、指の置かれたところだけ反射率が変わって散乱が起きる現象を利用している。また、時間が余ったことから、「ネットタンサー」や「ルンバ」などの小型ロボットを1~複数台制御するプロジェクトのプレゼンも急遽実施。JavaとProcessing上で動作する開発実行環境「Matereal」の紹介とプログラムの解説であった。ARToolKitも利用することから、テーマセッション向きであるとし、Actuated Reality、略してARとしている。

|  |  |

| arc@dmz氏。マルチタッチディスプレイと、ロボット制御用の実行環境の2つをプレゼンした | 製作したマルチタッチディスプレイの構成 | 家庭用小型ロボットを制御するための、JavaとProcessing上で動作する開発実行環境「Matereal」 |

オオトリは、同勉強会の幹事である橋本氏の「OpenCVをさらに簡単にするライブラリ~車輪の再発明に終止符なるか~」。ライブラリの開発において、同じ用途・目的なのに、どうしても自分の道具は自分で作りたいという傾向から、公開/非公開問わずライブラリが乱立してしまっているのが現状である。それをなくし、極力既にあるものを有効活用できるように、またしやすくすることを掲げたプレゼンである。OpenCVはコンピュータビジョンのライブラリとしてスタンダードになったと考えられ、車輪の再発明は終わったかに見えるが、橋本氏にいわせれば、使いづらい部分もあるという。特に画像処理未経験の人にとっては、OpenCVは敷居が高いそうだ。そこで、そうした問題点を解消し、初心者でもOpenCVを使えるよう、ラッパー「ExImage Library」(仮)を作ったということである。ちなみに、どのぐらいの初心者をターゲットにしているかというと、「構造体の配列を使ったことがあるけど、ポインタはちょっとね」というレベル。自分が当てはまるという人は、今後、公開されることになると思われるので、橋本氏の工学ナビをチェックしてみてほしい。

|  |

| 橋本氏。途中から司会を福地氏に譲り、実は会場でプレゼンの製作を開始し、最短記録の60分を樹立 | OpenCVはスタンダードになったといえるが、初心者には扱いづらく、橋本氏は特にここら辺が問題と指摘 |

以上、一見すると学術的な雰囲気だが、プレゼンの4分の1から3分の1ぐらいが、2次元の嫁に会いに行くかこっちに来させるかという内容であるという今回の発表内容。マジメなものもあるけど、ズッコケそうなコンセプトを大まじめ(?)に研究して披露しているというものも多く、実に楽しい勉強会であった。ぜひ登壇したみなさんには、発表された内容を実際に完成させていただきたい。第3回に関しては未確認だが、年1回ぐらいのペースで開催されるのではないかと思われるので、また来年の初夏から夏にかけてを期待しよう。

2009/6/24 17:14