|

記事検索 |

最新ニュース |

|

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

複数ロボットの操作や空間擬人化、笑いの増幅まで |

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

3月5日と6日、ユーザーインターフェイス、CSCW、可視化、入出力デバイス、仮想/拡張現実、ユビキタスコンピューティング、ソフトウェア工学をテーマにしたシンポジウム「インタラクション2009」が開催された。主催は情報処理学会 ヒューマンコンピュータインタラクション研究会(HCI)、情報処理学会グループウェアとネットワークサービス研究会(GN)、情報処理学会 ユビキタスコンピューティングシステム研究会(UBI)。協賛はGoogle株式会社。 毎年行なわれているシンポジウムで、人と人、人と機械のインタラクションに関する計算機科学や認知科学、社会科学、人文科学などの研究者や学生たちが集まった。なお今年は不況の影響で参加人数が減ったという。発表はキーノート、一般論文講演、そして実物のデモによるインタラクティブ発表からなるが、本誌では主に、ロボットや実世界インタラクションに関する発表をレポートする。なお今年のキーノートは東芝でハードディスク&DVDレコーダーの開発に従事する片岡秀夫氏が行なった。ベストペーパー賞は「“矢印タグ”を利用したテレビ用ウェブブラウザ操作方式」を発表したNTTの前田篤彦氏らが獲得した。

● 実世界インタラクションセッション

NiCTユニバーサルメディア研究センター超臨場感システムグループの吉田俊介氏は「gCubik:複数人で観察可能なキューブ型裸眼立体ディスプレイ-6面での実装とその対話操作に関する考察」と題して発表した。キューブ型裸眼立体映像ディスプレイ「gCubik」は、立体映像を使った人と人とのコミュニケーションを支援するためのデジタルツールである。GにはGroup sharing(複数人で共有)、Graspable(手に持てる)、Glazed showcase(ガラスケース)、Glasses free(裸眼)の意味が込められているそうだ。使っているディスプレイは3.5型のVGA。立体像の画質は約36×30ドット程度。 コンセプトは2007年に立案、その後、箱で立体映像を呈示する技術を突き詰めた。最終的には超高解像度で、実物を透明キューブのなかに収めたかのようなデバイスを理想としているという。原理的には異なる方向から見ると異なる光線を見ることになる凸レンズを使ったインテグラルフォトグラフィの原理を応用している。人は拡散反射を目で捉えて立体物を捕らえるが、レンズ位置で方向成分にサンプリングされた光線群要素画像群を凸レンズアレイを通して見ると立体映像が見えるのである。 ではそれを箱型にすればできるのかというとそうではない。一番の課題はどこから見ても立体的に見えなければならないことだったという。それぞれのレンズが配光できる範囲が、腕が届く範囲で視距離50cmくらい、箱が10cm四方だとするとおおよそ120度の視野を持たなければならない。それを凸凹レンズの組み合わせで実現。要素技術を組み合わせ、画質を向上させて、箱型立体ディスプレイとして完成させた。また抵抗膜方式のタッチパネルや加速度や姿勢が取れるモーションセンサー、スピーカをつけて、インタラクティブ機能を付加した。 レンダリング用PCは2台。それらが各々VGA画像を3組作ってディスプレイに呈示している。箱内部にオブジェクトを定義し、各レンズ位置に仮想的な視野角120度のカメラを設定してレンダリングさせている。将来はより高速、リアルタイムで動かすことを目指す。また、より高解像度にして、とりあえず今の市販小型ゲーム機くらいの解像度を3次元で実現できれば、売れる商品ができるのではないかと述べた。ハイビジョン程度の画質が必要だという。これから具体的なアプリケーションの実装を目指す。

大阪大学ヒューマンインタフェース工学講座の小川兼人氏は、大まかな形状の実物体の動きを使った検索技術について「実物体によるモーションクエリを用いた3次元形状モデル検索」と題して発表した。モーションセンサーや超音波センサーを装備したブロック(ActiveCube)を組み合わせ、それを動かすことで検索する。たとえばなんとなく飛行機のような形を作り、それを飛ばすような動きをすることで検索するのがモーションクエリである。モーション類似度はセンサーデータから特徴量を抽出して計算する。37種類のモデルを作ってテストを行なったところ、モーションクエリを使うことで86%を検索結果1位に提示でき、また形状クエリに組み合わせることでより素早い検索ができるようになったという。 また類似したモーションの処理やキャリブレーションの手間を削減するために、動きの中から「原動」を抽出。それだけをキャリブレーションすることを目指した。原動の抽出には自己組織化マップを使ってクラスタリングした結果を用いる。今は300モデルでテストを行なっており、漠然としたイメージだけを持っているときの検索などを用途としてイメージしているという。

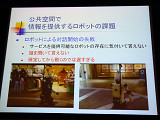

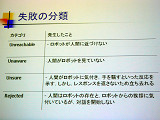

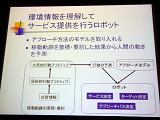

● 「人間行動理解に基づくインターフェース設計」セッション ・環境情報を理解してサービス提供を行なうロボットATRの佐竹聡氏は「環境情報を理解してサービス提供を行うロボットの実現」と題して、公共空間(ユニバーサルシティウォーク)でのRobovieを使ったサービス提供システムについて講演した。本誌でも何度か紹介している環境情報構造化プラットフォームの実証実験の一つである。 このシステムは、潜在的にサービスを必要としているユーザーを発見し、積極的にロボットから近づいてサービスを提供することがねらい。だが残念ながら現状では課題がある。たとえばロボットの存在に気づいてもらえなかったり、ロボットが話かけても対話相手としてみなしてもらえない。ではどうすればロボットと相手として見なしてもらえるのか。また人が地図の前に立ったのを発見したあとで動き出しても間に合わない。では、どのように近づけばロボットの存在に気づいてもらえるのか、そのためのモデル化を行なったというもの。 このシステムでは人間がどこに行くのか予測して、人が行きそうなところにロボットを動かしていく。そのためにのべ26,863人の軌跡データを蓄積したという。ロボットは対象の3m以内に入ったら対話を開始する。実験を行ない、対話の模様を記録、失敗を分類し、アプローチを分析したところ、失敗はざっくり4種類に分けられた。まずロボットが人間に近づけない、2番目は人間がロボットを見ていない、3番目はロボットがいることには気づくが自分に話しかけているのかどうかわからない。4つ目は人間がロボットを無視して拒否するパターンである。 これらの問題を解決するためには、ロボットが人間の軌跡を先回りし、人間の目線方向を意識しながら自分の行動をアピールするように、十分に素早く動かす必要がある。また、ロボットに対して人間側が話しかけたり、ロボットの注意が自分に向いているのか人間が確認したときには、ロボットも動き返して自分自身の志向性がどこに向いているのか人間に示さなければならない。 そこで移動軌跡データからSVM(Support Vector Machine)を使ってラベルづけを行なった「局所的行動プリミティブ」、それをクラスタリングした「大局的行動プリミティブ」を使って、人間が数秒後に行く確率が高いところを見つけ出しサービスを提供した結果、3割ほどの人にサービスを提供できるようになったという。これからは、単にロボットに対する物珍しさから人が話しかけたりするだけではなく、信頼関係を築くことを目指したいという。

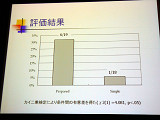

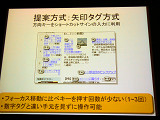

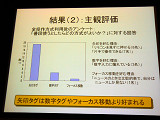

NTTサイバーソリューション研究所の前田篤彦氏らは「“矢印タグ”を利用したテレビ用ウェブブラウザ操作方式」と題して、テレビ上でウェブブラウズする時のリンク選択方式を提案した。テレビでウェブブラウズできる環境は整いつつあるが、まだ操作性には課題がある。既存の手法としては、リンク間を十字方向キーで移動していったり、カーソルの移動量を変えてリンク間を移動する方式などがあるが、これらはキーを押す回数が増えてしまう。リンクに数字を割り当てる方式もあるが、数字キーは視認しないと操作が難しい。ケータイの場合はディスプレイと手元が非常に近いが、テレビの場合はディスプレイと手元の間が離れているので問題になる。 前田氏らの提案は、方向キーをショートカットサインの入力に利用するという方式だ。格闘ゲームで技コマンドを入力するときに似ている。十字キーはテンキーと違ってホームポジションが非常に分かりやすく操作がしやすい。前田氏は実際に操作しながら発表を行なった。まず最初に決定キーを押す。そうすると矢印コマンドがリンク部分に現れる。たとえば「→↓」と表示されたリンクをクリックしたいときは、最初に「→」を入れる。すると、頭のコマンドが「→」以外のリンクのコマンドは消える。そのまま「↓」を入れて決定キーを押すとリンク先へ飛べる。 そのほか、矢印コマンドそれぞれの平均入力時間などを調べたり、画面上の選択されやすい位置にあるリンクに入力しやすいタグを割り当てるための調査などを行ない、実験結果を元にテストを行なった。必ずしも良いことばかりではなく、「画面がごちゃごちゃして見える」といった指摘などもあったそうだが、今後は、タグ割り当てアルゴリズムのさらなる改良や、フルブラウザ搭載のケータイ機器などへの搭載も考えるという。また、密集したリンクが選択できるようにするのは今後の課題だという。記者個人の感想としては、すぐにでも実装して欲しい操作オプションだと感じた。

● 複数台ロボットのオペレーション、ロボットの暮らしなど ~インタラクティブセッション インタラクティブセッションでは、ロボットを扱った研究のデモもいくつかあった。多くのデモ発表が行なわれていたが本誌では、インターフェイスとしてロボットあるいはロボットに類したものをタンジブルなインターフェイスとして用いていた研究を中心に紹介する。慶應義塾大学の野田誠人氏、大隈俊宏氏、藤本健太氏、大澤博隆氏、今井倫太氏、ATRの篠沢一彦氏らは「Blog Robot :身体表現を用いた携帯ブログ閲覧端末」をデモ。タカラトミー「i-SOBOT」をパーツとして利用し、携帯電話に取り付けた構造のロボットだ。今井氏によれば多くの人が書いているブログをそのままロボットコンテンツとしてねらった研究で、ブログに書いた文章のうち絵文字をそのままロボット動作のコマンドとして利用する。ロボットは専用のブログサーバ経由で送られたブログ内容をロボットの発話、ジェスチャで表現する。 ロボットにはGPSが内蔵されており、写真を撮影したときのGPSデータと参照することで現在位置と比較を行なって身振り動作を決定する。通常のブログにBlog Robot用のタグを付けるだけで利用できることが一番の特徴で、将来的にはあらゆるブログをロボットコンテンツとすることも可能だという。今井氏はこのようなやり方を用いることで「ロボットのコンテンツを爆発させたい」と語った。

今井氏らは大澤博隆氏、京都造形芸術大学の上林壮一郎氏らと「スキマロボット-空間に対する仮想的身体の付与」という研究もデモンストレーションしていた。これは昨年の「インタラクション」で行なっていた、身近な機器の擬人化への延長上にある研究で、今度は何もない空間に身体を付与してみようというもの。空間のまわりに目や手を付けることで、何もない空間を身体に見立てる。いわば不在を象徴的に顕在化させるものだ。上林壮一郎氏によると、何もないかのように見える空間にも実際にはさまざまな情報がある。たとえば温度や緯度経度といった場所情報などである。それらを感じさせたかったのだという。ユーザーはセンサーを使った簡単なインタラクションだけでもそこに息づかいのようなものを感じることができるのだそうだ。

豊橋技術科学大学の吉池祐太氏、岡田美智男氏らは「社会的存在価値を指向するソーシャルインターフェースの提案」と題して、「Sociable PC」をデモしていた。豆腐のような白くて柔らかくゆったり動くロボット型PCで、人と機械が対峙するのではなく並び立つ関係としてデザインしていきたいという研究の一環。何かの情報を積極的に伝達するのではなく、関わりや意味を共有するという形にへとインターフェイスを変えていきたいという。

岡田美智男氏は鴨田貴紀氏、竹井英行氏、角祐輝氏らと「Social Dinnig Table :家族の仲をとりもつ『コンコン』インタフェースの提案」もデモンストレーションした。これはダイニングテーブル上のポットやスナックプレート(Sociable Things)が、コンコンとテーブルを叩くと近くに寄ってくるというもの。家族同士の間をとりもつ「ソーシャルメディエータ」としての役割をロボット化した生活機器に持たせようとしている。テーブルの上には物体の位置や回転角度を検知するカメラが設置、テーブルにはマイクが仕込まれており、Sociable Thingsには無線LANモジュール、モーター、マイコン、落下防止センサー、バッテリなどが搭載されている。また椅子にはロータリエンコーダーが仕込まれている。今後は長時間のインタラクションを調べていくという。

電気通信大学の清水紀芳氏、長谷川昌一氏、慶應義塾大学大学院の稲見昌彦氏らは「ペン入力を用いたヒューマノイドロボットの運動・動作制御の提案」を出典した。システムは地面認識用マーカー、立方体マーカーを付けたヒューマノイドロボット、そしてカメラ付きタブレットPCからなる。まずユーザーはカメラ付きタブレットPCを使って、画像でロボットを捉える。そしてその画面上のロボットに対して直接タッチペンでコマンドを与えるというもの。現在は前進後退やしゃがむ、立つといった簡単な動作コマンドを与えられるだけだが、このシステムを使うことで、ユーザーは熟練なしにロボットに対して直感的にコマンドを与えられるという。地面の認識にはARToolKitが用いられている。今後はマーカーレスの手法を検討していくという。

東京大学の加藤淳氏、坂本大介氏、五十嵐健夫氏、慶応大学の稲見昌彦氏らは「複数台ロボットのマルチタッチディスプレイによる操作インタフェース」をデモンストレーションした。JST ERATOの「五十嵐デザインインターフェースプロジェクト」での研究で、複数台の小型ロボットをマルチタッチディスプレイを使って操作するもの。ディスプレイにはロボットを俯瞰した画像が提示され、それを直接さわって操作する。 操作方法は2タイプあり、1つは「直接指示」モード。もう1つは、接触面の形状をもとにロボットの動く方向を指示するベクトル場をロボットの周囲に形成する「ベクトル場」モード。ベクトル場モードでは全てのロボットがベクトル場にそって動く。たとえば外から内へとディスプレイ上で指を動かすと、周囲のロボットがそのベクトル場にひきずられて動く。同プロジェクトでは今後も、複数台のロボットと人間とのインタラクションの研究を進めていくという。

信州大学の秋山広美氏、小松孝徳氏らは「ユーザの直感的表現を支援するオノマトペ意図理解システム」として、IP Robot Phoneを用いたデモを行なっていた。オノマトペとは擬音語、擬態語、擬声語のこと。ぎざぎざとかカサカサといった言葉のことだ。その印象を音響特性から8次元で表現し、ロボットの動きとして再生した。デモではIP Robot Phoneの腕の動きとして表現していたが、任意の言葉に対応できる点が特徴で、出力は別にロボットでなくても構わないし、逆にもっと多自由度のロボットでも構わない。

電気通信大学の福嶋政期氏、橋本悠希氏、梶本裕之氏、目白大学の野澤孝司氏らは「筋活動の計測を用いた笑いの増幅」という研究をデモンストレーション。バラエティ番組では観客の笑い声が入っている。その笑い声によって笑いを誘発したり番組がますます楽しく感じるようにと意図してのものだ。このシステムは横隔膜近傍の表面筋電を使ってユーザーの笑いを検知、それに合わせて小型ロボット人形を一緒に笑わせる。笑いには薄ら笑いや爆笑、嘘笑いなどいろいろな種類があるが、きっかけがどんなものであっても笑いが笑いを増幅させていくという性質があるため、このシステムではどんな笑いであるかは問題視してない。とにかく笑いだしたらそれを増幅して、本当の笑いを生み出していく。

■URL インタラクション http://www.interaction-ipsj.org/index.html ■ 関連記事 ・ 「インタラクション2008」レポート ~擬人化されたシュレッダー、弱さを武器にするゴミ箱ロボットなど(2008/03/05)

( 森山和道 )

- ページの先頭へ-

|